當存儲系統的“體檢報告”頻頻預警——

數據重建進程持續搶占30%以上業務帶寬,引發關鍵業務響應延遲激增;

修復周期從常規24小時惡化至72小時+,數據脆弱期風險呈指數級攀升.....

這些異常指標絕非偶然波動!

而是傳統存儲架構在資源調度與可靠性層面的系統性缺陷——修復進程與業務I/O的資源爭奪直接威脅數據安全,并導致關鍵業務響應延遲加劇。

如何實現修復效率與業務穩定的“雙贏”,已成為存儲系統演進的核心命題。

為此,EDS存儲提出了「新解法」:

基于SSD與HDD完全解耦的可靠性架構,通過智能QoS調控+全局參與重建,實現修復任務與業務IO的智能平衡,在保障業務連續性的同時,大幅提升修復效率。

架構「新解法」

不僅實現故障隔離與精準修復

還能支持全SSD加速與彈性擴展

傳統Ceph方案存在致命缺陷,通常采用SSD與HDD混合加速方案:將存儲池按冗余策略(如EC4+2)劃分為多個分組,每個分組綁定一塊SSD,并將該SSD劃分為多個獨立分區,每個分區專用于加速組內一塊HDD。

以EC4+2冗余策略為例

Ceph系架構通過SSD加速存儲池性能方案在提升I/O效率的同時,帶來了以下問題:

交叉故障風險:單塊SSD故障導致整組HDD不可用,疊加其他故障時數據丟失風險增加。

修復效率低下:單塊SSD故障需重建144TB數據(以SSD:HDD=1:9,HDD容量為16T為例),理想狀態下修復時間也需要72小時。

擴展僵化:SSD與HDD需按比例擴容,無法獨立擴展SSD提升性能。

針對上述問題,EDS存儲在架構上將SSD與HDD完全解耦,通過數據熱度動態遷移與跨層異步IO調度,實現性能與容量的彈性平衡,規避傳統方案中SSD-HDD綁定的數據可靠性風險與緩存層擴展性問題。

1.跨層故障隔離

SSD與HDD完全解耦,SSD故障僅影響自身數據副本,HDD層數據完整可用且無需重建,徹底規避傳統方案中SSD故障造成的全磁盤組數據失效風險,以及SSD-HDD交叉故障導致的數據風險。

2.字節級精準重建

SSD層采用獨立冗余策略(如3副本),SSD單盤故障時僅需重建該SSD數據上的臟數據(分鐘級內可完成),數據修復范圍可精準到字節級別,相比傳統磁盤組方案,修復時間可縮短99%,窗口期數據丟失風險接近于零。

3.全SSD高性能引擎

前端業務讀寫100%由SSD性能層承載,基于熱力圖智能識別熱數據,確保高頻I/O全閃存響應,隨機讀寫性能提升10倍以上,時延降至亞毫秒級。

數據異步下沉至HDD容量層,通過智能回刷機制規避HDD寫入瓶頸,業務高峰期仍可保持穩定吞吐。

4.性能層彈性擴展

緩存層、持久化存儲層無綁定比例限制,單節點擴容一塊SSD即可線性提升全局緩存層容量,無需同步擴容HDD,實現“按需投資,即時生效”的性能升級。

數據修復「新解法」

智能QoS調控+全局參與重建

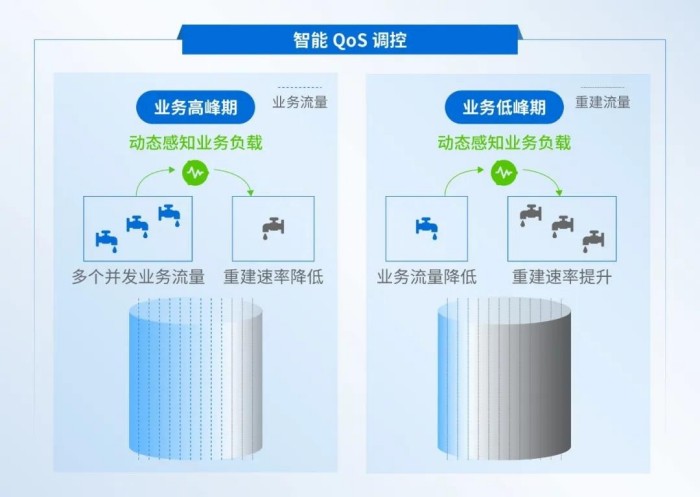

1.智能QoS調控、修復不搶業務資源

通過秒級精度監控業務IO流量、延遲及帶寬利用率,精準判斷業務壓力等級,實現動態感知業務負載。

自適應限速策略

業務高峰期:自動降低數據重建的任務并發數和任務優先級,優先保障業務資源供給,避免性能波動。

業務低谷期:提升重建任務的并發數與優先級,充分利用閑置資源,修復效率提升3倍。

2.全局參與重建,修復速度質的飛躍

全局參與重建技術通過創新的多源并行機制徹底改變了傳統數據修復模式,有效解決了傳統存儲系統在重建過程中面臨的資源利用率低下問題。

核心原理

一方面采用多源讀取策略,基于EC分片分布從多個健康故障域同時獲取數據分片,使聚合帶寬提升2-3倍,實現全局存儲資源的高效利用。

另一方面通過多目的端寫入技術,將恢復數據分塊并行寫入多塊磁盤,充分調用目標端磁盤IO與網絡帶寬資源,形成端到端的并行加速通道,從而大幅提升數據重建效率。

流程詳解

1. 選擇與故障盤不屬于同一故障域的完好硬盤作為數據源。

2. 通過跨域數據重構,將數據恢復至原故障盤所屬故障域內的其他正常硬盤(如修復數據1、數據a)。

深信服EDS存儲通過SSD與HDD解耦架構實現性能與容量的彈性平衡,結合智能QoS調控與全局參與重建技術,讓數據修復“隱身運行”!深信服EDS存儲希望通過持續的技術創新,為用戶的數字化轉型提供堅實的存儲底座。

明基投影機

明基投影機 堅果投影機

堅果投影機 科視投影機

科視投影機 極米投影機

極米投影機 SONNOC投影機

SONNOC投影機 寶視來投影機

寶視來投影機 視美樂投影機

視美樂投影機 當貝投影機

當貝投影機 哈趣投影機

哈趣投影機 WAP手機版

WAP手機版 建議反饋

建議反饋 官方微博

官方微博 微信掃一掃

微信掃一掃 PjTime

PjTime